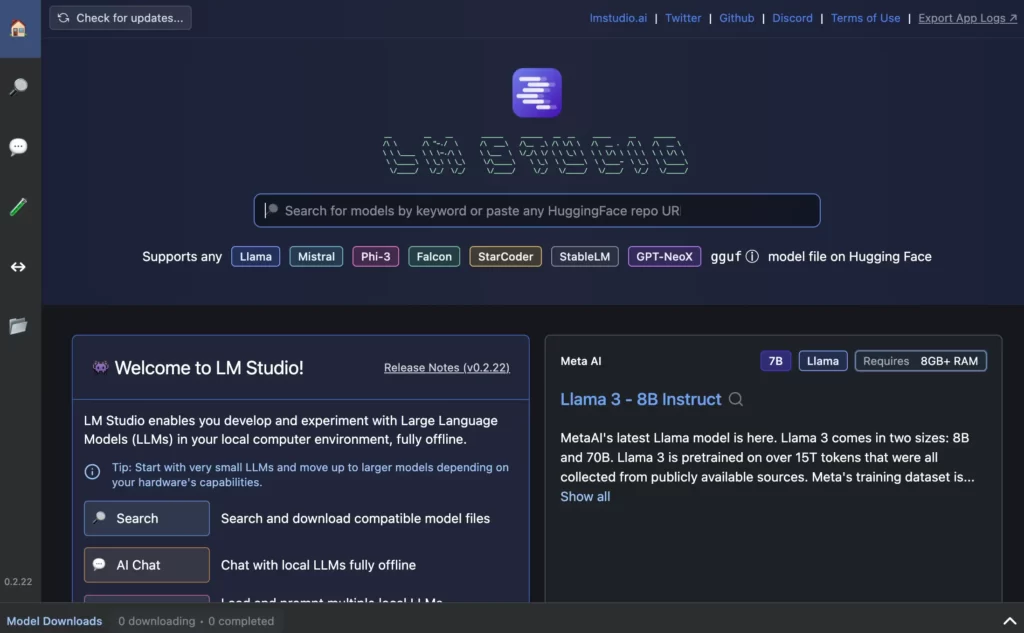

W szybko zmieniającym się świecie sztucznej inteligencji, Duże Modele Językowe (LLMs) stały się potężnymi narzędziami zdolnymi do rozumienia i generowania tekstu na poziomie zbliżonym do ludzkiego. Chociaż usługi oparte na chmurze oferują wygodny dostęp do tych modeli, rośnie zapotrzebowanie na lokalne, bezpośrednie eksperymentowanie z AI. Tutaj pojawia się LM Studio – przełomowa aplikacja desktopowa, która przynosi moc LLM-ów bezpośrednio na Twój komputer, oferując unikalne połączenie dostępności i kontroli dla entuzjastów AI, badaczy oraz deweloperów. LM Studio wyróżnia się jako kompleksowe rozwiązanie dla tych, którzy chcą badać możliwości LLM-ów bez ograniczeń związanych z usługami chmurowymi. Dzięki intuicyjnemu interfejsowi, wsparciu dla szerokiego wachlarza otwartych modeli oraz zaawansowanym funkcjom, takim jak lokalne punkty API, LM Studio demokratyzuje dostęp do najnowszej technologii sztucznej inteligencji.

W tym artykule zagłębimy się w możliwości, jakie oferuje LM Studio, przedstawiając praktyczne przykłady pokazujące jego wszechstronność i łatwość obsługi. Niezależnie od tego, czy jesteś ciekawym nowicjuszem, czy doświadczonym praktykiem AI, LM Studio otwiera nowe możliwości innowacji i nauki w ekscytującym świecie modeli językowych.

Czym jest LM Studio?

LM Studio to potężna aplikacja desktopowa zaprojektowana, aby przenieść możliwości Dużych Modeli Językowych (LLMs) bezpośrednio na Twój lokalny komputer. W swojej istocie LM Studio służy jako wszechstronna platforma do pobierania, uruchamiania i eksperymentowania z szeroką gamą otwartych modeli, takich jak Llama 3.1, Bielik-11B-v2.3-Instruct i Gemma 2. To przyjazne dla użytkownika narzędzie wypełnia lukę między usługami opartymi na chmurze a lokalnym przetwarzaniem, umożliwiając użytkownikom korzystanie z zaawansowanych modeli językowych bez potrzeby korzystania z zewnętrznych API czy połączenia z internetem.

Kluczowe cechy LM Studio sprawiają, że jest ono wszechstronnym narzędziem do eksploracji AI. Oferuje znajomy interfejs czatu, przypominający popularne chatboty AI, w którym użytkownicy mogą wchodzić w interakcje z wybranymi modelami w czasie rzeczywistym. Wbudowany system zarządzania modelami upraszcza proces odkrywania, pobierania i organizowania różnych LLM-ów. Co najważniejsze, LM Studio zawiera funkcję lokalnego serwera, który może nasłuchiwać na kompatybilnych z OpenAI punktach API, umożliwiając płynną integrację z istniejącymi narzędziami i przepływami pracy, które zwykle opierają się na usługach chmurowych.

Zapewniając wsparcie dla systemów macOS, Windows oraz Linux, LM Studio oferuje szeroką dostępność, dzięki czemu użytkownicy, od indywidualnych entuzjastów po profesjonalnych deweloperów, mogą wykorzystać potencjał lokalnych modeli LLM bez względu na preferowane środowisko komputerowe.

Dzięki połączeniu funkcji przyjaznych dla początkujących z zaawansowanymi możliwościami dla doświadczonych użytkowników, LM Studio staje się wartościowym narzędziem dla każdego, kto chce zgłębić świat dużych modeli językowych, niezależnie od tego, czy chodzi o badania, rozwój, czy osobistą eksplorację.

Pierwsze kroki z LM Studio

Rozpoczęcie pracy z LM Studio to prosty proces, który umożliwia szybkie eksperymentowanie z lokalnymi LLM-ami. Zanim zagłębisz się w fascynujący świat modeli AI, musisz skonfigurować aplikację na swoim komputerze. Oto najważniejsze kroki:

- Sprawdź wymagania systemowe

Upewnij się, że Twój komputer spełnia minimalne wymagania:- Dla macOS: Chip Apple Silicon (M1/M2/M3), macOS 13.4 lub nowszy, zalecane 16 GB+ RAM

- Dla Windows: System x64 lub ARM, wsparcie dla instrukcji AVX2 (dla x64), zalecane 16 GB+ RAM

- Dla Linux: Ubuntu 20.04 lub nowszy, architektura x64

- Pobierz i zainstaluj LM Studio

- Odwiedź oficjalną stronę LM Studio.

- Przejdź do sekcji „Pobierz”.

- Wybierz i pobierz odpowiednią wersję dla swojego systemu operacyjnego.

- Uruchom instalator i postępuj zgodnie z instrukcjami na ekranie, aby zakończyć instalację.

- Uruchom LM Studio

- Otwórz zainstalowaną aplikację LM Studio.

- Zostaniesz powitany głównym interfejsem z zakładkami: Chat, Discover oraz My Models.

Przykład 1: Czat z lokalnym modelem LLM

Teraz, gdy masz zainstalowane LM Studio, przejdźmy przez proces czatowania z lokalnym dużym modelem językowym. W tym przykładzie pokażemy, jak pobrać model, załadować go do pamięci i rozpocząć rozmowę. Skorzystamy z modelu Bielik-11B-v2.3-Instruct jako naszego przykładu, ale proces dla innych modeli dostępnych w LM Studio jest podobny.

- Pobierz model

- Przejdź do zakładki „Discover” w LM Studio.

- Wyszukaj model „Bielik-11B-v2.3-Instruct” w pasku wyszukiwania.

- Kliknij przycisk pobierania i poczekaj na zakończenie procesu.

- Załaduj model

- Przejdź do zakładki „Chat”.

- Kliknij przycisk ładowania modelu (zwykle u góry interfejsu).

- Wybierz pobrany model Bielik-11B-v2.3-Instruct z listy.

- Poczekaj, aż model zostanie załadowany do pamięci (może to chwilę potrwać).

- Rozpocznij rozmowę

- Po załadowaniu zobaczysz interfejs czatu.

- Wpisz swoją pierwszą wiadomość, np. „Cześć, z jakiego modelu korzystasz?”.

- Naciśnij Enter i poczekaj na odpowiedź modelu.

- Kontynuuj rozmowę, zadając kolejne pytania.

Jedną z wyróżniających się funkcji LM Studio jest wyświetlanie w czasie rzeczywistym metryk inferencji po każdej odpowiedzi modelu. Metryki te obejmują czas do pierwszego tokenu, czas generowania, szybkość generowania (tokeny na sekundę), powód zakończenia, użyte warstwy GPU, wątki CPU, czy włączono mlock (optymalizację pamięci), oraz licznik tokenów.

To narzędzie jest niezwykle przydatne dla użytkowników chcących zoptymalizować wydajność modelu lub lepiej zrozumieć procesy zachodzące „pod maską”. Na przykład można zobaczyć, jak różne ustawienia wpływają na prędkość generowania odpowiedzi lub jak blisko jesteś limitu kontekstu. Ten poziom wglądu jest rzadko dostępny w usługach chmurowych, co czyni LM Studio doskonałym narzędziem do nauki i optymalizacji wydajności modeli LLM.

Przykład 2: Wykorzystanie sesji wielomodelowych

Funkcja Sesji Wielomodelowych w LM Studio umożliwia użytkownikom ładowanie i interakcję z wieloma modelami jednocześnie, każdy z własnymi, niestandardowymi ustawieniami. Ta potężna możliwość pozwala na bezpośrednie porównanie wyników modeli, efektywne eksperymentowanie oraz tworzenie systemów zespołowych.

Przykład 3: Używanie LM Studio jako lokalnego serwera API

Funkcja lokalnego serwera API w LM Studio przekształca Twój komputer w potężne zaplecze AI, oferując punkty końcowe kompatybilne z OpenAI. To narzędzie umożliwia deweloperom korzystanie z lokalnych LLM-ów w ich aplikacjach, zapewniając większą kontrolę nad prywatnością danych, zmniejszenie opóźnień i tańsze rozwiązania AI bez korzystania z usług chmurowych.

Zaawansowane funkcje i dostosowywanie

LM Studio oferuje szeroki zakres zaawansowanych funkcji dla bardziej zaawansowanych użytkowników i deweloperów. Możliwość zapisywania presetów konfiguracji oraz dostosowywania szablonów promptów pozwala na precyzyjne dostosowanie interakcji z modelami LLM do indywidualnych potrzeb.

Podsumowanie

LM Studio daje użytkownikom możliwość wykorzystania potencjału lokalnych LLM-ów dzięki przyjaznemu interfejsowi, wsparciu dla wielu modeli oraz kompatybilnym z OpenAI punktom API. Dzięki tej platformie lokalne eksperymenty z LLM-ami stają się kluczowe dla innowacji, prywatności i spersonalizowanych rozwiązań. Niezależnie od tego, czy jesteś entuzjastą AI, deweloperem czy badaczem, LM Studio oferuje narzędzia do odkrywania, eksperymentowania i innowacji z modelami LLM.